如果说 AIGC 开启了内容生成的智能时代,那么 AI Agent 则有机会把 AIGC 的能力真正产品化。

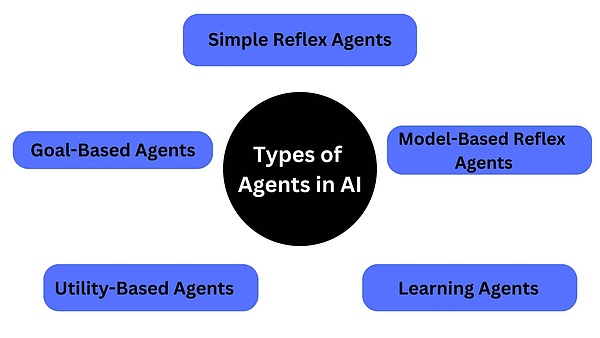

AI Agent 像一位更具象的全能员工,被称为是人工智能机器人的初级形态,能够如同人类一般观察周遭环境、做出决策,并自动采取行动。

比尔·盖茨曾直言,“掌控 AI Agent,才是真正的成就。届时,你将不再需要亲自上网搜索信息。”AI 领域的权威专家们同样对 AI Agent 的前景寄予厚望。微软 CEO 萨提亚·纳德拉曾预言,AI Agent 将成为人机交互的主要方式,能够理解用户需求并主动提供服务。吴恩达教授亦预测,在未来的工作环境中,人类和 AI Agent 将以更加紧密的方式协作,形成高效的工作模式,提高效率。

AI Agent 不单是技术的产物,更是未来生活与工作方式的核心。

这不禁让人回想,当 Web3 和区块链刚引起广泛讨论时,人们也常常用”颠覆”一词来形容这项技术的潜力。回顾过去几年,Web3 从最初的 ERC-20、零知识证明,逐渐发展到了与其他领域相融合的 DeFi、DePIN、GameFi 等。

若将 Web3 与 AI 这两大热门数字科技相结合,会不会产生 1+ 1>2 的效果呢?融资规模越来越庞大的Web3 AI 项目,能否为行业带来新的用例范式,创造新的真实需求?

AI Agent:人类最理想的智能助手

AI Agent 的想象力到底在哪里?网上盛传一个高分答案,“大语言模型只能编个贪吃蛇,而 AI Agent 可以编出一整个王者荣耀。”听起来很夸张,但并未言过其实。

Agent,国内通常翻译为“智体”。这一概念由“人工智能之父” Minsky 在 1986 年出版的《思维的社会》一书中提出,Minsky 认为社会中的某些个体经过协商之后可得出某一问题的解,这些个体就是 Agent。多年来,Agent 一直是人机交互的基石,从微软的剪辑助手 Clippy 到 Google Docs 的自动建议,这些早期形态的 Agent 表现出了个性化交互的潜力,但在处理更复杂任务方面能力仍然有限。直到大语言模型(LLM)的出现,Agent 的真正潜力才得以被挖掘。

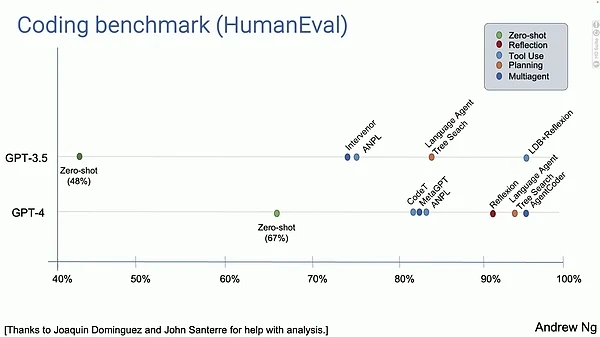

今年 5 月,AI 领域权威学者吴恩达教授在美国红杉 AI 活动上分享了关于 AI Agent 的演讲,在其中,他展示了其团队做的一系列实验:

让 AI 去写一些代码并运行,对比不同 LLM 和工作流程得出的结果。结果如下:

-

GPT-3.5 模型:准确率 48%

-

GPT-4 模型:准确率 67%

-

GPT-3.5 + Agent:高于 GPT-4 模型的表现

-

GPT-4 + Agent:远高于 GPT-4 模型,非常出色

的确。大多数人在使用 ChatGPT 这种 LLM 时,方式通常是:输入一段提示词,大模型会立即生成答案,不会自动识别和纠正错误删除重写。

相比之下,AI Agent 工作流程是这样的:

首先,先让 LLM 写一个文章大纲,如有必要,先在互联网上搜索内容进行调研分析,输出初稿,然后阅读草稿并思考如何优化,如此循环往复、多次迭代,最终输出一篇逻辑严谨、错误率最低的高质量文章。

我们可以发现,AI Agent 与 LLM 的区别在于,LLM 与人类之间的交互基于提示词(prompt)进行。而 AI Agent 仅需设定一个目标,它就能够针对目标独立思考并做出行动。根据给定任务详细拆解出每一步的计划步骤,依靠来自外界的反馈和自主思考,自己给自己创建 prompt,来实现目标。

因此 OpenAI 对 AI Agent 的定义是:以 LLM 为大脑驱动,具有自主理解感知、规划、记忆和使用工具的能力,能自动化执行完成复杂任务的系统。

当 AI 从被使用的工具变成可以使用工具的主体,就成为了 AI Agent。这也正是 AI Agent 可以成为人类最理想智能助手的原因所在。例如,AI Agent 能够基于用户历史线上互动,了解并记忆用户的兴趣、偏好、日常习惯,识别用户的意图,主动提出建议,并协调多个应用程序去完成任务。

就如同在盖茨的构想中,未来我们不再需要为不同的任务切换到不同的应用中,只需用平常的语言告诉电脑和手机想做什么,根据用户愿意共享的数据,AI Agent 将提供个性化的响应。

单人独角兽公司正在成为现实

AI Agent 还能够帮助企业打造以“人机协同”为核心的智能化运营新模式。越来越多的业务活动将交由 AI 来完成,而人类则只需要聚焦于企业愿景、战略和关键路径的决策上。

就像 OpenAI 首席执行官 Sam Altman 曾在采访中提到过这样一个引人注目的观点,随着 AI 的发展,我们即将进入“单人独角兽”时代,即由单人创办并达到 10 亿美元估值的公司。

听起来天方夜谭,但在 AI Agent 的助力下,这个观点正在成为现实。

不妨做个假设,现在我们要创办一家科技初创公司。按照传统方法,显然我需要雇佣软件工程师、产品经理、设计师、营销人员、销售和财务人员,各司其职但都由我来协调。

那么如果使用 AI Agent 呢,我可能甚至都不需要雇佣员工。

-

Devin — 自动化编程

替代软件工程师,我可能会使用今年爆火的 AI 软件工程师 Devin,它能帮我完成所有前端和后端的工作。

Devin 由 Cognition Labs 开发,被称为是“世界上第一个 AI 软件工程师”。它能够独立完成整个软件开发工作,独立分析问题、做出决策、编写代码并修复错误,均可自主执行。大大减轻了开发人员的工作负担。Devin 在短短半年内就获得了 1.96 亿美元的融资,估值迅速飙升至数十亿美元,投资方包括 Founders Fund、Khosla Ventures 等知名风险投资公司。

虽然 Devin 仍未推出公开版本,但我们可以从另一个最近爆火 Web2 的产品 Cursor 一窥潜力。它几乎可以为你完成所有工作,将一个简单的想法在几分钟内转化为功能性代码,你只需要发号施令,就能「坐享其成」。有报道称,一个八岁的孩子,在没有任何编程经验的情况下,居然使用 Cursor 完成代码工作并建起了一个网站。

-

Hebbia — 文件处理

替代产品经理或财务人员,我可能会选择 Hebbia,它能帮我完成所有文档的整理和分析。

与 Glean 侧重企业内文档搜索不同,Hebbia Matrix 是一个企业级的 AI Agent 平台,借助多个 AI 模型,帮助用户高效地提取、结构化、分析数据和文档,从而推动企业生产力的提高。令人印象深刻的是,Matrix 能一次性处理多大数百万份文档。

Hebbia 在今年 7 月完成了 1.3 亿美元 B 轮,a16z 领投,Google Ventures、Peter Thiel 等知名投资者参投。

-

Jasper AI — 内容生成

替代社媒运营和设计师,我可能会选择 Jasper AI,它能帮我完成内容的生成。

Jasper AI 是一个 AI Agent 写作助手,旨在帮助创作者、营销人员和企业简化内容生成流程,提高生产力和创作效率。Jasper AI 能够根据用户要求的风格生成多种类型的内容,包括博客文章、社交媒体帖子、广告文案和产品描述等。并根据用户的描述生成图片,为文本内容提供视觉辅助。

Jasper AI 已获得 1.25 亿美元的融资,并在 2022 年达到了 15 亿美元的估值。根据统计数据,Jasper AI 已帮助用户生成超过 5 亿个单词,成为使用最广泛的 AI 写作工具之一。

-

MultiOn — 网页自动化操作

替代助理,我可能会选择 MultiOn,帮我管理日常任务、安排日程、设置提醒,甚至是规划出差行程,自动预订酒店,自动安排网约车。

MultiOn 是一个自动化的网络任务 AI 代理,能够帮助在任何数字环境中自主执行任务,例如帮助用户完成在线购物、预约等个人任务,提升个人效率,或帮助用户简化日常事务,提高工作效率。

-

Perplexity — 搜索、研究

替代研究员,我可能会选择英伟达 CEO 都在每天使用的 Perplexity。

Perplexity 是一个 AI 搜索引擎,能够理解用户的提问,拆分问题,然后搜索和整合内容,生成报告,以向用户提供清晰的答案。

Perplexity 适用于各类用户群体,例如学生和研究人员可以简化写作时的信息检索流程,提高效率;营销人员可以获取可靠数据支持营销策略。

以上内容仅为想象,当下这些 AI Agent 的真正能力和水平尚不足以替代各行各业中的精英人才。正如 Logenic AI 联合创始人李博杰所言,目前 LLM 的能力还只是入门级水平,远远达不到专家级,现阶段的 AI Agent 更像是一个干活比较快但不太可靠的员工。

然而,这些 AI Agent 凭借各自的特长,正在助力现有用户在多样化场景中提高效率和便利性。

不仅仅限于科技公司,各行各业都可以在 AI Agent 的浪潮中获得益处。在教育领域,AI Agent 可以根据学生的学习进度、兴趣和能力提供个性化的学习资源和辅导;在金融领域,AI Agent 可以帮助用户管理个人财务,提供投资建议,甚至预测股票走势;在医疗领域,AI Agent 可以帮助医生进行疾病诊断和治疗方案的制定;在电商领域,AI Agent 还可以作为智能客服,通过自然语言处理和机器学习技术自动回答用户咨询,处理订单问题和退货请求,以此提高客户服务效率。

Multi-Agent:AI Agent 的下一步

在上一节关于单人独角兽公司的设想中,单一的 AI Agent 在处理复杂任务时面临着局限性,难以满足实际需求。而运用多个 AI Agent 时,由于这些 AI Agent 基于异构 LLM,集体决策困难,能力有限,以至于还需要人类充当这些独立 AI Agent 之间的调度员,协调这些服务于不同应用场景的 AI Agent 去工作。这便催生了“Multi Agent(多智体框架)”的兴起。

复杂问题往往需要融合多方面的知识和技能,而单个 AI Agent 的能力有限,难以胜任。通过将不同能力的 AI Agent 进行有机组合,Multi-Agent 系统可以让 AI Agent 发挥各自的长处,取长补短,从而更有效地解决复杂问题。

这非常类似于我们实际中的工作流程或组织结构:由一个领导者分配任务,拥有不同能力的人,负责不同的任务,每个工序执行的结果给到下一个工序,最终得到最后的任务成果。

在实现过程上,由较低级别 AI Agent 执行各自的任务,而由级别较高的 AI Agent 分配任务,并对它们的完成情况进行监督。

Multi-Agent 还能模拟我们人类的决策过程,就像我们遇到问题时会找人商量一样,多个 AI Agent 也可以模拟集体决策的行为,为我们提供更好的信息支持。例如由微软开发的 AutoGen 就满足了这一点:

-

能够创建不同角色的 AI Agent。这些 AI Agent 具有基本的对话能力,能够根据接收到的消息,生成回复。

-

通过 GroupChat 来创建由多个 AI Agent 参与的群聊环境,在这个 GroupChat 有一个管理员角色的 AI Agent 管理其他 AI Agent 的聊天记录、发言者顺序、终止发言等。

如果应用到单人独角兽公司的设想里,我们可以通过 Multi-Agent 架构创建几个不同角色的 AI Agent,比如项目经理、程序员或者主管。把我们的目标告诉它们,让它们任意去想办法,我们只要在一旁听汇报,如果觉得有意见或者它们做得不对的地方,就让它们改,直到满意为止。

相比单一的 AI Agent,Multi-Agent 可以实现:

-

可扩展性:通过增加 AI Agent 的数量来处理更大规模的问题,每个 AI Agent 处理任务的一部分,使得系统能够随着需求的增长而扩展。

-

并行性:天然支持并行处理,多个 AI Agent 可以同时在问题的不同部分上工作,从而加速了问题解决。

-

决策改进:通过聚合多个 AI Agent 的洞察力来增强决策制定,因为每个 AI Agent 都有自己的视角和专业知识。

随着 AI 技术的不断进步,可以想象 Multi-Agent 框架将在更多行业发挥更大的作用,并推动 AI 驱动的各类新解决方案的发展。

AI Agent 之风,吹向 Web3

迈出实验室,AI Agent 和 Multi-Agent 道阻且长。

暂且不论 Multi-Agent,即便是当下最先进的单一 AI Agent ,其需要的算力资源和计算能力在物理层面仍有明确的上限,无法做到无限扩展。一旦面临极其错综复杂、计算量密集的任务,AI Agent 无疑将会遭遇算力瓶颈,性能大打折扣。

再者,AI Agent 和 Multi-Agent 系统本质上是一种集中式的架构模式,这决定了它存在着极高的单一故障风险。更重要的是,OpenAI、微软、谷歌等公司基于闭源大模型的垄断商业模式,严重威胁独立、单一的 AI Agent 创业公司的生存环境,使得 AI Agent 无法顺利利用庞大的企业私有数据来使它们变得更聪明、更有效率。AI Agent 之间亟需民主化的协作环境,使得真正有价值的 AI Agent 得以服务更广阔的需求人群,为社会创造更大的价值。

最后,虽然与 LLM 相比,AI Agent 更贴近产业,但其发展基于 LLM,而当前大模型赛道的特点是技术门槛高、资金投入多、商业模式尚且发展不成熟,AI Agent 通常很难获得融资以持续更新迭代。

Multi-Agent 的范式是 Web3 助力 AI 的绝佳角度,已经有不少 Web3 开发团队正在这些方面投入研发提供解决方案。

AI Agent 和 Multi-Agent 系统通常需要大量的计算资源来进行复杂的决策和处理任务。Web3 通过区块链和去中心化技术,可以构建去中心化的算力市场,使得算力资源可以在全球范围内更加公平和高效地分配和利用。Akash、Nosana、Aethir、 IO.net 等 Web3 项目可以对 AI Agent 决策和推理提供计算能力。

传统的 AI 系统往往是集中式管理,导致 AI Agent 面临单点故障和数据隐私问题,Web3 的去中心化特性可以使得 Multi-Agent 系统更加分散和自治,每个 AI Agent 可以独立地运行在不同的节点上,自主执行用户提出的需求,增强了鲁棒性和安全性。通过 PoS、DPoS 等机制建立针对质押者、委托者的激励惩罚机制,可以促进单一 AI Agent 或 Multi-Agent 系统的民主化。

在这方面,GaiaNet、Theoriq、PIN AI、HajimeAI 都有非常前沿的尝试。

-

Theoriq 是一个服务于“AI for Web3”的项目,希望通过 Agentic Protocol 建立 AI Agents 的调用和经济系统,普及 Web3 的开发和许多功能性场景,为 Web3 dApp 提供可验证的模型推理能力。

-

GaiaNet 以节点为基础的 AI Agent 创建和部署环境,以保护专家、用户的知识产权与数据隐私为出发点,抗衡中心化的 OpenAI GPT Store。

-

HajimeAI 则在两者基础上发力 AI Agent 工作流在实际需求中的建立和针对意图本身的智能化、自动化,呼应 PIN AI 提到的“AI 智能的个性化”。

-

同时,Modulus Labs 与 ORA Protocol 分别在 AI Agent 的 zkML 和 opML 的算法方向取得了进展。

最后,AI Agent 和 Multi-Agent 系统的开发和迭代往往需要大量的资金支持,而 Web3 可以通过前置流动性的特点帮助有潜力的 AI Agent 项目获取宝贵的早期支持。

Spectral 和 HajimeAI 均提出了支持发行链上 AI Agent 资产的产品构想:通过 IAO(Initial Agent Offering)发行代币,AI Agent 可以直接从投资者获得资金,同时成为 DAO 治理的一员,为投资者提供参与项目发展和分享未来收益的机会。其中 HajimeAI 的 Benchmark DAO 希望通过众筹加代币激励的方式,将去中心化的 AI Agent 评分和 AI Agent 资产发行有机结合起来,打造 AI Agent 依托 Web3 融资和冷启动的闭环,也是比较新颖的尝试。

AI 潘多拉魔盒已然开启,置身其中的每个人既兴奋又迷茫,热潮下是机遇还是暗礁,无人知晓。如今,各行各业都已不再是 PPT 融资时代,无论多么前沿的技术,也只有落地才能实现价值。AI Agent 的未来注定是一场漫长的马拉松, 而 Web3 正确保它不会在这场竞赛中黯然退场。